さて今回は、2017年12月上旬に「Neural Information Processing Systems(NIPS)」カンファレンスの基調講演でマイクロソフト社のリサーチャー、ケイト・クロフォード氏が明らかにした、進化する人工知能(AI)への懸念?についてじっくり考察してみましょう。

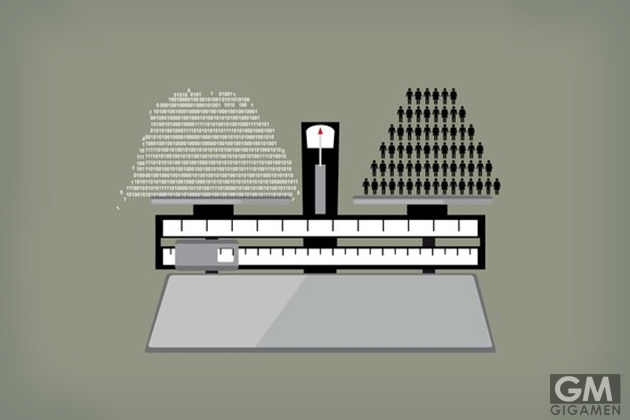

ポイントはズバリ!AIのつくり手たちってAIが持つ機能は分かっても、AIが何かしら判断を下した時の理由までは説明不可能なんですって。

例えばの話、AIがガンバって黒人とゴリラの判別を試みた際に誤認でタグ付けミスった画像処理アルゴリズムをまんま使って増殖させちゃうかもしれませんよね。

果たして、AIがブラックボックス化のまま高度化し医療等に適用された時、一体誰が判断の正当性をジャッジできるのでしょうか?

AIが歩むべき正しい道が分かる人間プチャヘンザ!

まず、知り合いの病理ドクターいわく、既存の診断ですらブラックボックスがわんさかあるから今更どっと増えても何とも思わねーくらいのほほ~んとしたリアクションに唖然としちゃいましたよ。

やはり、もうこうなったら人間が生み出すアルゴリズムでAIに自我が芽生えるまで日々作り込んで成長させていくっきゃないですね。

そして、将来的にはナゼその答えに終着したのかを可視化しながら人間の思考をスッキリ整理してくれる頼もしい存在になってほしい!と切に願ってしまいます。

参照元:WIRED

この記事をシェア